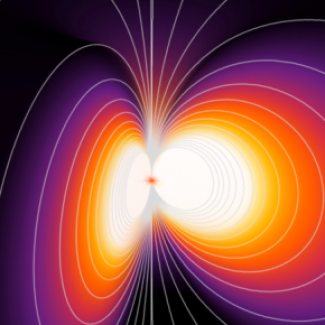

Le cerveau code numériquement les informations

Le cerveau enregistre de nouvelles informations quotidiennement et a besoin d’accéder rapidement aux anciennes. Des chercheurs du laboratoire Équipes Traitement de l'Information et Systèmes (ETIS - CNRS/CY Cergy Paris Université/ENSEA) ont obtenu des résultats qui permettent de mieux comprendre ce phénomène qui a des implications dans la construction d’un réseau de neurones en intelligence artificielle.